🧠AI文字走しの第一歩。ColabとWhisperの準備だけしよう!

セッション中のやりとり、ちゃんと録音してるのに「どこで何話したっけ?」とあとから探すのにひと苦労。

「あのときの一言、すごく響いたのに…」と、思い出そうとしても出てこない。

そんな経験、ある人多いんじゃないでしょうか?

そんなとき、AIが文字起こし+整理までやってくれたら… もう最高ですよね。

しかも、録音ファイルを“ポイッ”と渡すだけでOK。

自動で文字がズラッと現れて、「あ、これこれ!」とすぐに振り返れる。

そんな未来が、もうすぐそこまで来ています。

……ただし! その前に、ちゃんと道具の準備をしておかないと、AIくんは静かにスルーします。

ということで、この回では「最初の一歩」を一緒に踏み出していきましょう◎

🚪 今回のゴール

この回では、「Colabって何?」「Whisperってどうやって使うの?」という疑問に答えながら、AI文字お越しの準備だけをしていきます。

📦 完了するとこうなる!

- ✅ Google Colabを開いて

- ✅ Whisperのモデルが使える状態になって

- ✅ Google Driveともつながっている

これで、次回からの「文字走し実行」が超ラクになります。

✋ Colabってなんだっけ?という方へ

Google Colabの基本操作(開き方・コードの実行・Drive連携など)に不安がある方は、

まずこちらを見ておくと安心です👇

🔗Google Colabって何者?開けてビックリ、動かして感動の超入門!

📥 Whisperのモデルをインストールしよう

Whisper(ウィスパー)は、OpenAIが開発した「音声を文字にしてくれるAI」です。

たとえば録音データを渡すと、話した内容をテキスト化してくれる、いわば"自動書き起こし係"のような存在です。

このWhisperを使うには、まずGoogle Colabの中に"インストール"する必要があります。

これは、スマホにアプリを入れるようなイメージです。

📝 ワンポイント補足!

今は試作段階なので、WhisperをColabにインストールして使えば無料で文字起こしできます。

ただし、これは「Colabの中だけで自己完結する使い方」だからできること。

将来的にこの仕組みを本格的なサービスとして提供したい場合は、OpenAIの「Whisper API」や「ChatGPT API」を使って、安定した処理や自動化を組み込む必要が出てきます。

つまり、

🛠 今は“お試しモード”!でも“本番”ではAPIの力を借りる!

くらいのイメージでOKです◎

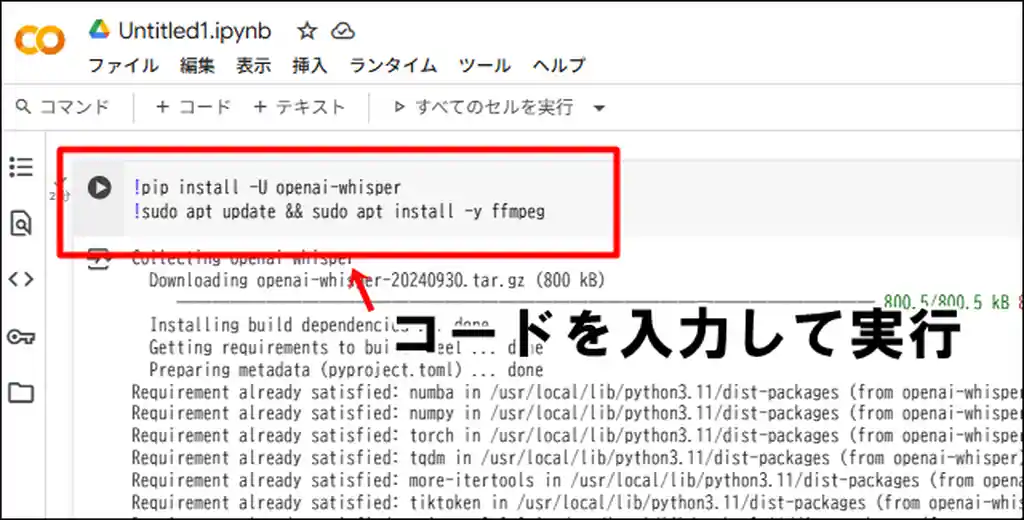

✅ Whisperのインストールコード

以下のコードをコピーして、Colabの「コードセル」に貼り付けてください👇

!pip install -U openai-whisper

!sudo apt update && sudo apt install -y ffmpegopenai-whisper:Whisper本体をColabに入れるための命令です。ffmpeg:音声ファイルの読み込みや変換を手伝ってくれるツールです(Whisperが音声を理解するために必要なもの)。

📌 パソコンがインストール作業をしている間は、画面がたくさん動きますが大丈夫です。コーヒーでも飲みながら気長に待ちましょう☕(3分ほど)

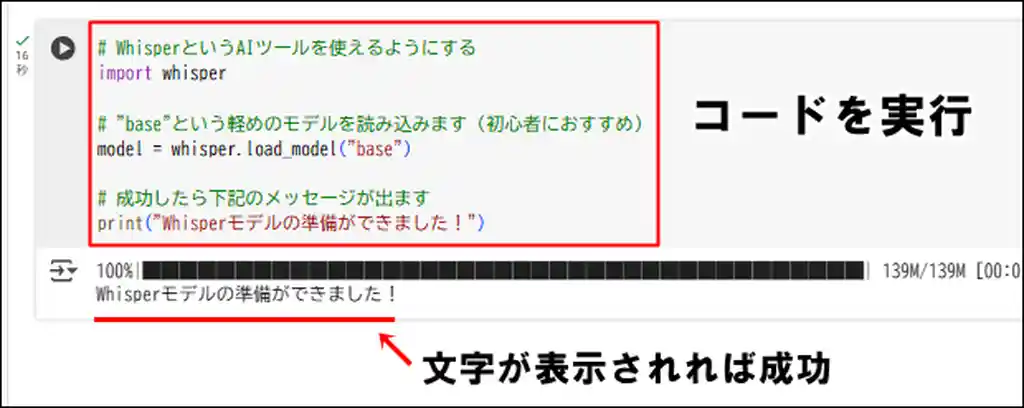

🧰 Whisperを使える状態にしてみよう

インストールが終わったら、Whisperのモデルを呼び出して「使える状態」にしてみましょう。

以下のコードをColaboのセルに入れて実行してね👇

# WhisperというAIツールを使えるようにする

import whisper

# "small"という処理が速くて、そこそこ高精度のモデルを読み込みます(初心者におすすめ)

model = whisper.load_model("small")

# 成功したら下記のメッセージが出ます

print("Whisperモデルの準備ができました!") このコードを実行すると、「Whisperモデルの準備ができました!」と表示されるはずです。

これが出れば、WhisperがColab上でちゃんと動くようになったという合図です。

💡 モデルには "base" や "small"、"large" など色々種類がありますが、今回は 処理が速くて、そこそこ高精度、しかもColabでも安定しやすい 「small」を使っています。

まずはこれで十分!あとで必要に応じてグレードアップもできます◎

🔗 Google Driveとつなごう

今回は成果物に直接関係ないので、試したい人だけやってみて!

今後、音声ファイルを保存したり読み込んだりする場面が出てきます。

そのために、Google ColabとGoogle Driveをつないでおく必要があります。

ColabでDriveを使うには、以下のコードを実行します👇

from google.colab import drive

drive.mount('/content/drive')このコードを実行すると、画面にリンクが表示されます。

- リンクをクリックして、Googleアカウントにログイン

- 「このアプリにアクセスを許可しますか?」と聞かれるので、許可を選択

- 表示された認証コードをコピー

- Colabの入力欄にそのコードを貼り付けてEnter

これで、Google Driveの中身(自分のファイル)がColab上から使えるようになります。

ちゃんとつながっているか確認したい場合は、次のコードを実行してみましょう👇

!ls /content/drive/MyDriveこれは、あなたのGoogle Driveの中身を一覧表示してくれるコマンドです。

ファイル名やフォルダ名がずらっと出てきたら、接続成功です!

これでDriveの中にある音声ファイルを読み込んだり、文字起こし結果を保存したりする準備が整いました◎

🎉 まとめ

ここまでおつかれさまでした!

この回でやったことは、「ColabでWhisperを動かす準備」です。

これで、次回からの「音声ファイルを使った文字起こし」にスムーズに進める準備が整いました。

| 工程 | やったこと |

|---|---|

| ✅ Colabを開いた | ノートブックを作って、コードを入力する場所を準備した |

| ✅ Whisperをインストール | AI文字起こしツールをColabに入れた |

| ✅ モデルを読み込んだ | Whisperの基本モデル(small)を読み込んで使えるようにした |

| ✅ Driveを連携した | ファイルの保存・読み込みができるようにした |

| ✅ 動作確認をした | Driveの中身を確認して、接続成功をチェックした |

次回は、いよいよ文字起こしをしていきます。

音声ファイルが文字化されるのって「なんかすげ~」って感動しちゃいます😆

🔗 関連リンク|AI秘書ツール制作シリーズ

- 1️⃣ 第1回|文字起こし①:Whisperを動かす準備だけしよう!←(今ここ)

- 2️⃣ 第2回|文字起こし②:録音ファイルをポイッと、Whisperで文字起こし!

- 3️⃣ 第3回|要点抽出①:ChatGPTで要点だけ抜き出してみた!

- 4️⃣ 第4回|要点抽出②:抽出結果をToDo形式に整えてみた

- 5️⃣ 第5回|要点抽出③:提出用レポートに仕上げてみよう!

- 6️⃣ 第6回|感情分析①:発言ごとの感情をAIで数値化してみた!

- 7️⃣ 第7回|感情分析②:感情の波をグラフで見える化してみた!

- 8️⃣ 第8回|感情分析③:“気づき”を引き出すレポートをつくろう

- 9️⃣ 第9回|感情分析④:発話のバランスから見えてくること(比率分析編)

- 🔟 第10回|感情分析⑤:感情のゆらぎから“気づき”を拾ってみよう!

- 🏁 【第11回|完結】これが完成形!ポータルに載せる「report.json」をColabで作ろう

💡 迷ったらこちらも